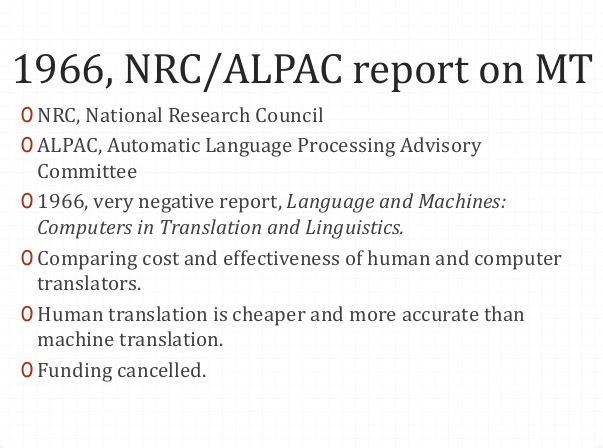

El año 1966 fue muy importante en la historia de la traducción automática. En ese año se redactó el informe ALPAC (Automatic Language Processing Advisory Committee), del National Research Council, que enumera una serie de conclusiones desfavorables a cerca de este método, entre ellas:

Concepción errónea de los proyectos.

Mal o escaso conocimiento del lenguaje.

Técnicas informáticas inadecuadas.

La recomendación general de este informe fue no continuar invirtiendo tiempo ni dinero en el proyecto. El desfinanciamiento que sufrió fue una consecuencia directa de la problemática que planteaba la semántica del texto a traducirse y que parecía imposible de sortearse. Esto, entonces, siempre importaría un intenso trabajo de edición posterior. Haciendo caso omiso de la situación, IBM continuó desarrollando esta tecnología.

La investigación sobre la traducción automática se trasladó así a otros lugares. En primera instancia a Canadá (dada la necesidad que planteaba su condición de país bicultural) y Europa (el desarrollo de la Unión Europea trajo aparejada la necesidad del intercambio de información multilingüe), y luego a Japón.

Como producto de las investigaciones llevadas a cabo en estos lugares, se desarrollaron distintos sistemas de uso comercial. Uno de los primeros y más conocidos fue SYSTRAN, creado por Peter Toma, en la Universidad de Georgetown. Inicialmente Toma diseñó el programa con el par ruso-inglés para ser utilizado por la Fuerza Aérea de los Estados Unidos. Al ser mucho más avanzado que el resto de los programas existentes en ese momento, se utilizó también en organismos de gran relevancia mundial como la OTAN y la OIEA (Organización Internacional de Energía Atómica).

En 1976 se conoció el programa Météo. Esta tecnología fue el resultado de una investigación que había comenzado en el año 1965 en la Universidad de Montreal con la financiación del Consejo Nacional de Investigación de Canadá, bajo la dirección del profesor Guy Rondeau. En 1971 el programa se rebautizó como TAUM (Traduction Automatique Université de Monrtéal). Météo, como se lo comercializó más tarde, fue diseñado para traducir partes meteorológicos.

En la década de 1980, en proyectos de segunda generación, se incorporaron reglas estructurales más complejas, datos estadísticos y la distinción de normas gramaticales. De entre estos proyectos uno de los más destacados fue EUROTRA, para la comunidad europea, que luego fue cancelado por falta de financiación.

La década siguiente marcó un punto de inflexión para la traducción automática. Fue entonces que comenzó a evaluarse el método que se conoce como estadístico (SBMT). Este se basa en el análisis de corpus de textos que ya habían sido traducidos y es el más utilizado hoy en día. A diferencia de los otros sistemas, no se basa en reglas lingüísticas sino en la comparación de un corpus bilingüe. Uno de los primeros de estos sistemas fue desarrollado por la empresa IBM, Candide, a partir del análisis de textos del parlamento canadiense (en inglés y francés).

Los avances tecnológicos de esta época (internet) permitieron la celeridad en la expansión de la traducción automática. Se crearon sistemas aptos para PC (PC-Translator y Power Translator) y en 1997 se conoció el primer servicio de traducción automática en internet, Babel Fish. En ambos casos la base tecnológica era SYSTRAN.

Diez años más tarde Google presentó su primer sistema de traducción, Google Translate, basado en reglas (RBMT). No es sino hasta 2011 que la empresa comienza a utilizar el sistema estadístico.

http://www.infoamerica.org/documentos_pdf/bar06.pdf

http://cvc.cervantes.es/lengua/anuario/anuario_10-11/alcina/p02.htm

Damián Santilli y otros (2016) Manual de informática aplicada a la traducción, Buenos Aires: Editorial CPTCBA